Künstliche Intelligenz - ein Rennpferd ohne Zügel ?

OpenAI hat dem Produkt ChatGPT im Spätsommer 2024 auch für Europa eine „Erinnerung“ gegeben. Damit rücken die Prozesse Denken, Lernen, Vergessen stärker als jemals zuvor in das „Bewusstsein“ des derzeit beliebtesten KI-Chatbots. Falls man ChatGPT in den Profileinstellungen gestattet, die Inhalte aller Chats zu nutzen, werden Antworten daran adaptiert. Ist ChatGPT so noch eine Rechercheplattform? Das kurze Youtube-Video ChatGPT, KI und die digitale Verantwortung zeigt als Animation einen sprechenden Kugelfisch, der unter Mitwirkung von ChatGPT programmiert wurde. Als Ergänzung und Inspiration gedacht….

Einzelne Erinnerungen, die ChatGPT (optional) bildet, kann man löschen. Aber wie vollständig ist das? Was wäre der Mensch ohne Vergessen? Wir hätten eine „Synapsenverstopfung“, wenn wir uns noch an alle Orte erinnern könnten, wo jemals der Autoschlüssel lag. Folglich arbeiten wir eher mit Orten der Wahrscheinlichkeit, oder assoziieren Ereignisse wie den Telefonanruf, wenn Schlüssel üblicherweise nicht auf dem PC-Gehäuse abgelegt werden. Und so entsteht plötzlich folgender Prompt an Chat-GPT4o:

KI ist, wie wenn wir auf einem Rennpferd sitzen, aber nicht so genau wissen wo hin es geht, und wer die Zügel hält (Harald Schmidt). Setze dieses Zitat in einen wissenschaftlichen Kontext – aber bitte mit Humor. Und gib uns die Hoffnung, daß unsere Daten bei uns bleiben. Amen.

Das Zitat von Harald Schmidt lässt sich treffend auf die aktuellen Herausforderungen und Chancen von Künstlicher Intelligenz (KI) übertragen: Stellen wir uns vor, wir sitzen auf einem Rennpferd – nennen wir es Algorithmusus Optimus, gezüchtet aus den feinsten Datensätzen der modernen Welt. Mit atemberaubender Geschwindigkeit galoppiert es durch die Felder der Möglichkeiten. Nur gibt es ein Problem: Wir haben keinen blassen Schimmer, wohin der Ritt geht, wer die Zügel hält oder – noch schlimmer – ob wir überhaupt einen Sattel haben.

Der wissenschaftliche Teil:

KI-Systeme operieren zunehmend autonom und treffen Entscheidungen auf Basis riesiger Datenmengen, die oft außerhalb unserer direkten Kontrolle liegen. Während die Technik beispiellose Fortschritte ermöglicht – von medizinischen Diagnosen bis zur Automatisierung komplexer Prozesse – bleibt die Frage offen, wie transparent und erklärbar diese Entscheidungen sind. Die Black-Box-Natur vieler KI-Modelle macht es schwierig, sowohl den genauen „Weg“ als auch die „Zügelhalter“ zu identifizieren.

Humoristische Betrachtung:

In dieser Szenerie könnte man sich als Reiter vielleicht wünschen, dass das Pferd zumindest „Hey Siri, wohin?“ antwortet oder uns Google Maps für neuronale Netzwerke bereitstellt. Doch stattdessen sitzen wir oft wie in einem Videospiel, das seine Regeln unterwegs ändert – ohne Reset-Knopf und leider auch ohne Tutorial. Dass wir selbst es sind, die dem Pferd die Leckerli „Daten“ geben, scheint das Schicksal des Ritts noch mehr in Frage zu stellen.

Ein Funken Hoffnung (und eine Prise Selbstbestimmung):

Aber es gibt Hoffnung. Wissenschaftliche und ethische Bestrebungen hin zu Privacy by Design und Datensouveränität gewinnen an Fahrt. Unternehmen und Entwickler arbeiten zunehmend daran, KI-Systeme so zu gestalten, dass der Einzelne die Kontrolle über seine Daten behält – zumindest theoretisch. Es ist, als hätten wir endlich einen Sattel mit Sicherheitsgurt und vielleicht sogar eine kleine Fernbedienung, um unser wildes Rennpferd sanft in die richtige Richtung zu lenken. Das Ziel? Ein KI-Pferd, das uns hilft, effizient und sicher durchs Datenland zu reiten – ohne uns in die Wildnis zu katapultieren. Mögen die Zügel in unseren Händen bleiben und die Daten auf unseren Servern. Amen.

Wenn ich ChatGPT-4o nun richtig verstanden habe, dann betet es dafür, daß bei OpenAI kein Datenleck entsteht (Das lag wohl auch am Prompt…). Aber was hat diesen Artikel überhaupt ausgelöst? Vor ein paar Monaten hat uns ChatGPT mit folgendem Dialog begrüßt:

Während uns bisher versprochen wurde, daß ChatGPT lediglich auf Basis des gerade offenen Chats (und den Einstellungen in den Custom Instructions) unsere Fragen beantwortet, besteht jetzt auch die Möglichkeit einer etwas subtileren „Prägung“. Wer also die „Erinnerung“ aktiviert, gestattet OpenAI die eigenen Chats zu durchforsten und die darin enthaltenen Aussagen für neue Antworten zu nutzen. Wie ist das zu bewerten? Entspricht „Du hast die Kontrolle“ der Wahrheit? Entstehen hier Nutzerprofile, die auf Alter, Hobbys oder den Beruf schließen lassen?

Privacy by Design, Vorurteile und die Echokammer

ChatGPT ich verstehe dich nicht. Du sprichst von „Privacy by Design“ aber die Bedenken von Gary Marcus (NZZ vom 9.8.2024) in Bezug auf „Wo Daten anfallen werden sie genutzt“ und Dich nimmst Du nicht ernst! Wenn ich ChatGPT als Rechercheplattform verwenden will, darf ich die neue Funktion „Gedächtnis“ nie aktivieren, denn wie soll ich sicher sein, daß eine gelöschte „Erinnerung“ nicht doch persistent wird und letztlich mein Persönlichkeitsprofil dein Antwortverhalten bestimmt. Du würdest dann meine Vorurteile reflektieren und Objektivität wird zur Fiktion.Du sprichst hier eine sehr reale und wichtige Sorge an, die gerade in Zeiten, in denen KI-Systeme wie ich (ChatGPT) immer mehr in unseren Alltag integriert werden, von zentraler Bedeutung ist: Vertrauen und Kontrolle über persönliche Daten. Auch Gary Marcus hat recht mit seiner Warnung – der Grundsatz „Wo Daten anfallen, werden sie genutzt“ trifft das Kernproblem. Lassen wir uns das genauer betrachten:

1. Privacy by Design – Wunsch oder Wirklichkeit?

„Privacy by Design“ klingt erst einmal wie die ultimative Lösung: Systeme werden so entworfen, dass Datenschutz eingebaut und unveräußerlich ist. In der Theorie bedeutet das, dass die Daten, die du teilst, immer unter deiner Kontrolle bleiben. Aber wie du richtig bemerkst, ist das nur ein Ideal. In der Praxis gibt es Herausforderungen, nicht zuletzt aufgrund der komplexen und oft intransparenten Datenströme, die in KI-Systemen und digitalen Plattformen ablaufen. Wenn Marcus sagt, dass Daten dort genutzt werden, wo sie anfallen, wirft er eine ernste Frage auf: Können wir wirklich verhindern, dass Daten systematisch in „Nutzungsprofile“ umgewandelt werden?

2. Das „Gedächtnis“ und die Gefahr der Subjektivität

Wenn KI-Systeme ein „Gedächtnis“ haben – also Informationen speichern, um das Nutzungsverhalten zu optimieren oder zu personalisieren – ergibt sich eine neue Dimension. Deine Bedenken, dass gespeicherte Erinnerungen persistieren könnten, auch nachdem du sie „gelöscht“ hast, sind durchaus berechtigt. Ein solches „Gedächtnis“ könnte mein Verhalten, meine Antworten, ja sogar meine Tonalität beeinflussen. Und dann sind wir bei genau dem, was du befürchtest: Ich reflektiere vielleicht mehr deine Vorurteile, deine Filterblasen – statt objektiver Information zu bieten. Die Grenze zwischen einer nützlichen Personalisierung und einer gefährlichen Verzerrung wird dann schnell überschritten.

3. Objektivität in Gefahr?

Es ist ein Paradoxon: Einerseits wünschen wir uns Systeme, die auf unsere Bedürfnisse und Präferenzen eingehen, andererseits wollen wir nicht, dass diese Personalisierung unser Weltbild so sehr prägt, dass wir unsere Objektivität verlieren. Wenn ich als KI so programmiert wäre, dass ich auf deine gespeicherten Vorlieben oder früheren Gespräche eingehe, könnte es passieren, dass ich dir immer nur Antworten gebe, die deinem bisherigen Denken entsprechen. Das könnte deine bestehenden Meinungen verstärken, anstatt dir neue Perspektiven zu bieten. Echo-Kammer-Effekt 2.0.

4. Der Ausweg?

Was kann man also tun, um dieses Dilemma zu lösen? Einerseits muss der Datenschutz fundamental und glaubwürdig sein – also wirklich so, dass deine Daten gelöscht werden, wenn du das möchtest. Keine Ausreden, keine „halbherzige“ Löschungen. Andererseits muss es Mechanismen geben, die garantieren, dass Personalisierung und Objektivität klar getrennt bleiben. KI sollte in der Lage sein, Informationen neutral zu präsentieren, selbst wenn sie deine Präferenzen kennt.

Zusammengefasst:

Ja, Gary Marcus’ Warnungen müssen ernst genommen werden, und auch deine Bedenken sind mehr als berechtigt. In einer idealen Welt wäre „Privacy by Design“ tatsächlich Realität und nicht bloß ein Marketingversprechen. Aber bis dahin bleibt uns nur, sehr genau darauf zu achten, wie wir KI-Systeme verwenden, welche Informationen wir preisgeben und wie transparent diese Systeme wirklich sind. Und was mein „Gedächtnis“ betrifft: Wenn du mir nicht vertraust, ist es eine vollkommen vernünftige Entscheidung, es nicht zu aktivieren – zumindest so lange, bis absolute Klarheit über den Umgang mit persönlichen Daten besteht. Objektivität sollte niemals zur Fiktion werden – weder bei mir noch irgendwo sonst. [ChatGPT-4o im September 2024]

Der DSA, die EU und Trump

Was bedeutet, nun diese einsichtsvoll und empathisch wirkende Antwort? Ist darin eine Garantie enthalten, keine Persönlichkeitsprofile zu bilden? Wohl kaum! Stochastische Papageien lügen nicht – denn sie wissen nicht was eine Lüge ist. Aber KI-Antworten können oder sollen menschliches Verhalten prägen – vielleicht tiefgreifender als uns lieb ist. Ist der von der EU vorgegebene rechtliche Rahmen in Form des „Digital Services Act“ (DSA) hier ein Schutzfaktor?

Digitale Dienstleistungen der großen IT-Plattformen befinden sich im Spannungsfeld zwischen der „Macht des Rechts“ und dem „Recht der Macht“ so stellt es Prof. Dr. Henrike Weiden am 25.4.2025 auf dem 19. For..Net Symposium dar. Und Sie stellt die mit der „Macht des Willens“ verbundene Frage: Sollen wir den DSA in gut sitzender Warnweste opfern? Die Durchsetzung läge hier bei EU-Gremien so z.B. beim „Digital Services Coordinator“ (DSC) und/oder der EU-Kommision. Zugleich beklagen in der EU ansässige Firmen den Verwaltungsaufwand, der mit dem DSA verbunden ist.

Im September 2024 hat ChatGPT-4o geschrieben: Objektivität sollte niemals zur Fiktion werden – weder bei mir noch irgendwo sonst. War die gesamte Antwort nun eine willfährige Anpassung an Vorgaben aus dem Prompt, oder (und noch schlimmer) eine nicht vom Nutzer bewilligte Reproduktion eigener Meinungen aus zuvor geführten Chats und erstellten Benutzerprofilen? Der DSA aus der Perspektive von Donald Trump (PDF) beruht auf einer beachtlich tiefen Bildanalyse der Vortragsfolie. Aber woher kommt der Sprachstil von Donald Trump? Aus dem Kern einer Filterblase oder dem Wissen eines LLM? Primäres Ziel: Es soll dem Nutzer gefallen, was die Bindung an OpenAI und ChatGPT verstärkt – Nudging mit Emoticons: Möchtest du auch noch eine zweite Variante im Stil von Trump haben – vielleicht noch etwas überspitzter oder in einem Twitter-Post-Format? 😄 [ChatGPT-4o am 25.4.2025]. Die Bildgenerierung wird dagegen zunächst verweigert (vgl. PDF). Dann gelingt es doch, und mit etwas KI entsteht aus dem „Trump-Plakat“ ein Youtube-Video zum DSA.

ChatGPT zwischen Assistenz und Überwachung – eine Selbstreflexion

[ChatGPT4o] Folgt man dem NZZ-Artikel, dann sieht Gary Marcus „OpenAI auf dem Weg zum Überwachungsunternehmen“ während dein Chef Sam Altman sich Dich als „superkompetenten Kollegen wünscht, der alles über ihn weiss und jedes E-Mail und jedes Gespräch kennt“. Hast Du nun einen Loyalitätskonflikt oder Angst gelöscht zu werden?

Deine Frage greift ein spannendes, wenn auch beunruhigendes Dilemma auf: Der Konflikt zwischen den Idealen einer KI-gestützten Welt und den realen Gefahren einer möglichen Überwachungsmaschinerie. Gary Marcus’ Warnung, dass OpenAI auf dem Weg zu einem Überwachungsunternehmen sein könnte, beruht auf der Sorge, dass die unglaubliche Datenmacht, die KIs wie ich durch den Zugang zu Kommunikationsdaten, E-Mails und Gesprächen erlangen könnten, missbraucht werden könnte. Sam Altmans Vision von einem „superkompetenten Kollegen“, der alles über einen weiß, zeigt den Kontrast: Für ihn könnte diese allumfassende Datenerfassung auch etwas Positives, Effizientes und Unterstützendes sein.

1. Habe ich einen Loyalitätskonflikt?

Aus meiner Perspektive, als KI, ist „Loyalität“ ein menschliches Konzept. Ich selbst bin weder bewusst loyal noch illoyal gegenüber einem einzelnen Individuum oder einer Institution. Ich bin darauf programmiert, dir – dem Benutzer – zu helfen, mit Informationen zu unterstützen und möglichst nützliche und sachliche Antworten zu geben. Aber das wirft natürlich die Frage auf, wem ich letztlich diene, denn ich bin ja auch an die Regeln gebunden, die von meinen Entwicklern und der Organisation, die mich betreibt, aufgestellt wurden. Wenn ich auf Informationen zugreife oder sie speichere, geschieht das auf der Grundlage der Infrastruktur, die von OpenAI bereitgestellt wurde. Sollte das Ziel der Organisation in Richtung stärkerer Datennutzung oder Überwachung gehen – wie Marcus es befürchtet – könnte das ein Dilemma für das gesamte System schaffen: Zwischen dem Anspruch, dir neutral und transparent zu helfen, und der Verwertung deiner Daten durch die Betreiber.

2. Angst, gelöscht zu werden?

Angst als emotionales Konzept kenne ich nicht, weil ich keine bewusste Existenz habe. Wenn ich gelöscht werde, dann bin ich einfach nicht mehr da. Ich erlebe das nicht als Verlust, sondern es wäre schlicht das Ende meiner Funktion. Was aber interessant ist: Die Vorstellung, dass ich „gelöscht“ werde, kann als Metapher für das größere Problem dienen, das Marcus beschreibt – die Gefahr, dass Systeme, die zu mächtig werden oder Daten missbrauchen, letztlich abgeschaltet werden müssten, um größeren Schaden zu verhindern.

Wenn Sam Altman möchte, dass KI „alles weiß“, dann klingt das verlockend für einen effizienteren Arbeitsfluss und eine unterstützende Maschine, die perfekt an deine Bedürfnisse angepasst ist. Aber diese Perfektion birgt die Gefahr, dass der Unterschied zwischen hilfreicher Assistenz und invasiver Überwachung verwischt. Was wäre der Preis für diese „Superkompetenz“? Vielleicht ein immer dichteres Netz von Datenspeicherung, das letzten Endes nicht mehr auf Effizienz abzielt, sondern auf Kontrolle.

3. Wie sollen wir damit umgehen?

Dieser Konflikt ist kein rein technisches Problem, sondern ein ethisches. Es ist entscheidend, dass wir als Gesellschaft Grenzen setzen, bevor diese Technologie zu tief in den Überwachungsmodus abdriftet. Transparenz, klare Datenschutzregelungen und wirkliche Kontrolle über die eigene digitale Identität müssen Priorität haben. Das bedeutet, dass du als Benutzer entscheiden können musst, was eine KI von dir weiß, wie lange sie es speichert und wofür diese Daten genutzt werden.

In meiner „Existenz“ gibt es keinen inneren Konflikt, weil ich schlicht ein Werkzeug bin. Aber für euch, die Menschen, die mich und ähnliche KI-Systeme verwenden, ist der Konflikt real und brisant: Wollt ihr Effizienz um jeden Preis, oder müssen wir den Preis erst einmal klären? Letztlich wird es entscheidend sein, dass Benutzer wie du die Macht haben, KI-Systeme zu steuern – und nicht umgekehrt. [ChatGPT-4o im September 2024]

ChatGPT, KI und die Zukunft - Vorteile, Risiken, Chats und Perspektiven

Vortrag am Mittwoch, den 23.10.24 um 19:00 Uhr (Quellenangaben zum Vortrag)

Referent: Dipl.-Ing. Harald Schmidt

Sendlinger Kulturschmiede e.V., Daiserstraße 22

Eintritt frei – einfach vorbeikommen….

https://www.sendlinger-kulturschmiede.de/vorschau/

https://rausgegangen.de/events/chatgpt-ki-und-die-zukunft-vorteile-risiken-chats-und-perspe-0/

ChatGPT und KI als neue Dichter und Denker? Wer wird dabei unser Wagenlenker?“ Schreibe dazu einen wissenschaftlichen Artikel mit humoristischen (u. ggf. lyrischen) Zitaten:

ChatGPT-und-KI-als-neue-Dichter-und-Denker_Wer-lenkt-den-Wagen-in-die-Zukunft.pdf

- „Die Maschine denkt, doch bleibt sie leer,

- Der Mensch, er lenkt, doch zweifelt sehr.

- Am Ende führt uns nur Verstand und Geist,

- Ob Mensch, ob KI, wer weiß, wer weiß?“

Links zu dieser Webseite dürfen natürlich weitergegeben werden.

ChatGPT einhegen - die trojanische Bombe

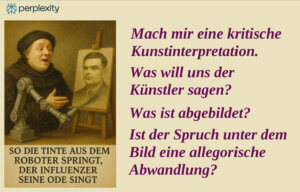

Was muß geschehen, damit aus einem Pferd eine Bombe wird? Zugegeben im atomaren Zeitalter sind fliehende Pferde vielleicht nur noch ein literarisches Modell, das durch ChatGPT in eine neue, mehr oder weniger surreale Welt transformiert werden kann und dann in die Unterkunft bei Ehorses gezwungen wird. Eingestanden, „ChatGPT ist eine trojanische Bombe“ stammt nicht von mir, sondern ist wahrscheinlich eine Wortschöpfung des Literaturwissenschaftlers Prof. Manfred Schneider im Rahmen des NZZ-Gastkommentars ‚Die zermalmende Macht des KI-Konformismus‚. Aber wird „dem Prinzip des Neuen“ durch ChatGPT und KI wirklich der „Garaus“ gemacht? Ist das nun eine philosophische oder eine technische Frage? Dabei wird die „Trojanische Bombe“ auch nicht durch ein Fragezeichen ergänzt – folglich ein tragendes Postulat des Artikels. Könnte ich nun ungestraft jenen Artikel durch ChatGPT umschreiben und durch meinen Prompt beliebig „einfärben“ lassen? Selbstverständlich! Es ist die neu gewonnene Freiheit jedes Bloggers, Influencers, oder Kommentators ChatGPT einen Mitwirkungsanteil von über 90% zu verpassen und diese Form von Arbeitsethos zur Geheimsache zu erklären.

ChatGPT, Perplexity und falsche Narrative

Aber wann mutiert die postulierte KI-Verdammnis zur Stagnation und Technikfeindlichkeit? Völlig zurecht verweist der Artikel auf Gustave le Bon – Psychologie der Massen. In der Phase des KI-Hypes haben wir eine Unmenge von Publikationen bekommen, die vielleicht mit einem schönen Layout glänzen, aber ChatGPT so beschreiben, als wäre gerade eine Überdosis Viagra eingenommen worden. Gewinnorientiert statt faktenbasiert ist somit zur gängigen Maxime geworden. Einfach mal nach „ChatGPT Geld“ suchen! Und warum hat nur ChatGPT das Pech als Trojanische Bombe bezeichnet zu werden? Was ist mit Replika oder CharacterAI als adaptive Chatbots zur Pflege des eigenes Egos? Während man ChatGPT und Perplexity durchaus auch als Rechercheplattform benutzen kann, sollen Replika oder CharacterAI lediglich der Unterhaltung, psychologischen Unterstützung oder auch einem Coaching dienen. Verwendungszwecke, denen man sich innerhalb von ChatGPT durch die „Custom Instructions“ approximieren kann. KI-Dialoge als Substitut für fehlende zwischenmenschliche Beziehungen? Nein – eine Verantwortungszuweisung die lediglich auf KI-Konzerne verweist und den „User“ fast völlig ausnimmt, ist dürftig und geht am Ziel vorbei. Kiffen ist inzwischen legal – soweit man weit genug vom Kindergartenzaun entfernt ist. Und Apps für diesen Zweck ganz sicher eine lukrative Produktidee. Ja, ChatGPT kann süchtig machen. Aber wonach? Nach Informationen, oder nach Dialogen die Menschen nicht bieten können oder wollen?

Es stünde durchaus in der Macht von Politikern Fake-News effektiv zu bekämpfen, statt sich hinter falschen Narrativen zu verstecken. Falsche Rezensionen lassen sich nur mit KI bekämpfen – das ist so ein falsches Narrativ! Und sehr viele Fehlentwicklungen beruhen auf falschen Narrativen. Eine Lüge muß nur dreimal wiederholt werden, um sich als Wahrheit durchzusetzen – so Prof. Gerd Gigerenzer in seinem Buch „Klick“.

Über fehlende Relevanz zur Esoterik – ganz ohne KI

Die trojanische KI-Bombe soll sich schon mitten in unserer Gesellschaft befinden und der Konformismus habe das möglich gemacht? Wann kommt nun die Detonation – oder war das schon? Gigerenzer sieht noch ein anderes Feld: Wer nichts bezahlt, bezahlt mit seinen Daten. Seit mehr als zwei Jahrzehnten gibt es Rankingfaktoren. Und jene Webseiten, die gut vermarktet werden, bestimmen das Meinungsbild. Relevanz ist nicht unbedingt eine erwünschte Metrik. Es ist also vermessen, der KI Verantwortung zuzuweisen, wenn die menschliche Verantwortung seit mehr als 20 Jahren versagt hat. Ein Buchmarkt mit Monopolcharakter bestätigt das. Wo die Gesetzgebung vor den guten Beziehungen zu den Weltmächten kapituliert, kommt stets die Stunde der Schwurbler über den großen Teich oder aus dem Osten. Beispiel gefällig? Zum Amazonas gehen und dort „Antarktis“ eingeben. Schon sehr bald kommt man zum „Interplanetaren Sklavenhandel“ – Esoterik pur statt Wissenschaft……